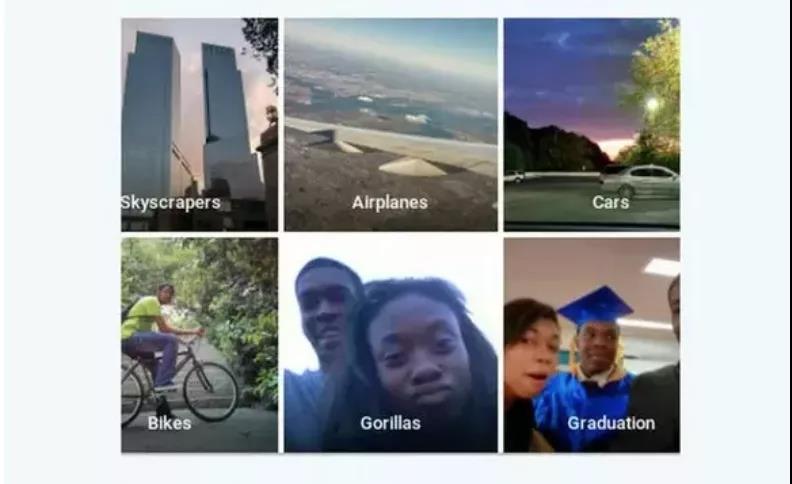

英国《每日邮报》 6 月 27 日发布的一段视频最近在Facebook忽然火了起来,但其引发关注的原因并不是因为视频本身,而是因为它被打上的“标签":这是一段关于一位黑人的视频,但所有观看该视频的用户都会收到一条提示,询问他们是否想“继续观看有关灵长类动物的视频”。

前 Facebook 内容设计经理 Darci Groves 在推特发布了这一发现,并且很快引发众怒。

之后,Facebook很快下线了这一推荐,并且公开道歉。

“这显然是一个不可接受的错误,我们在意识到发生这种情况后立即禁用了整个主题推荐功能,这样我们可以调查原因并防止这种情况再次发生,”Facebook 发言人 Dani Lever 在给《今日美国》的一份声明中说。

“正如我们所说,虽然我们对人工智能进行了改进,但我们知道它并不完美,我们还有很多的进步空间,”她说。“我们向任何可能看到这些冒犯性内容的人道歉。”

争论:人类不是灵长类吗?

不过,事情发生后,也有人在相关社区表示,不必太过敏感,毕竟人类都是灵长类动物的一种,ai的判定也没有问题。

也有黑人程序员兄弟在社区表示,不要太过敏感,“我个人同意承认黑人的肤色在视觉上与某些非人类灵长类动物的图像更相似,并且可以理解为什么这个问题不是程序员的偏见,而是一个复杂的计算机视觉问题,计算机很容易发现相似之处,但要训练一个神经网络了解为什么图像彼此相似但不相关,就非常困难了。”

而反对者则认为,AI只会反馈它学习的数据,出现这样的标注结果,也反映出facebook整体标注系统的大问题,而据Facebook自己的说法,其人工智能是使用用户上传的图像进行训练的。

毕竟,这也不是Facebook的ai系统第一次出这种”种族主义“的问题。”

Facebook并非唯一,科技公司坎坷的“种族主义”难题

近些年,Facebook 在为算法“去种族偏见”的问题上付出了不少代价,过程颇为坎坷。早在2018年,该公司就曾被曝出丑闻,允许广告商在如住房和就业等行业做广告时排除某些少数群体。Facebook当时也同样使用“技术性”这一口径来回避相关问题,例如并不是按种族而是按所谓的“多元文化”对用户进行分类。

因此,Facebook在种族问题上一直持有比较谨慎的态度,也为此付出了很多努力。去年7月,The Verge报道称,Facebook 正在组建新的内部团队,致力于研究其主要社交网络和 Instagram 的种族偏见,特别是其使用人工智能训练的算法是否会对黑人、西班牙裔和其他少数族群产生不利影响。Facebook 发言人当时告诉The Verge,该团队将“负责确保公平和公平的产品开发存在于我们所做的一切中” 。“我们将继续与 Facebook 的负责任的人工智能团队密切合作,以确保我们正在关注我们各自平台上的潜在偏见。”

不过,从现在的结果来看,Facebook引以为豪的这一整改影响非常有限。

当然,Facebook不是唯一一家因自动化系统中的种族偏见而受到抨击的科技公司。

2015 年,谷歌的应用程序错误地将黑人识别为“大猩猩”,并且为此道歉。不过两年后,有媒体发现谷歌的解决方案非常简单粗暴,直接从搜索结果中删除了相关标签,也就是说,禁止将任何图片标记为大猩猩、黑猩猩或猴子。

谷歌这种“宁可错杀一千,不肯放过一个”的做法或许残暴,但也从某种程度上说明了图片分类这一看似简单的能力仍然存在比较大的问题。对于实现真正的人工智能,我们任重而道远。

相关报道:

https://www.theverge.com/2021/9/4/22657026/facebook-mislabeling-video-black-men-primates-algorithm

https://www.nytimes.com/2021/09/03/technology/facebook-ai-race-primates.html

https://www.usatoday.com/story/tech/2021/09/03/facebook-video-black-men-primates-apology/5721948001/

https://www.wired.com/story/when-it-comes-to-gorillas-google-photos-remains-blind/

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。